据外媒报道,美国麻省理工学院(MIT)的工程师们正在设想可以让机器人与家庭助手更像,可以遵循高级、Alexa(语音助手)类型的命令,比如“去厨房给我拿个咖啡杯来。”而为了执行此种高级别的任务,研究人员认为,机器人需要具备与人类一样的物理环境感知能力。

(图片来源:MIT)

MIT航空航天学系助理教授Luca Carlone表示:“为了做出决策,首先需要对周围的环境建立一个心理模型,这对于人类而言是轻而易举的事情。” 但对于机器人而言,却特别困难。机器人只会将摄像头看到的像素值转化为对世界的理解。因此,Carlone与学生们一起,为机器人研发了一种空间感知模型,该模型模仿了人类感知和在世界中导航的方式。

该款新模型称为3D动态场景图(3-D Dynamic Scene Graphs),能够让机器人快速生成周围环境的3D地图,其中还包括物体和语义标签(例如,一把椅子,一张桌子)以及人、房间、墙壁和机器人在环境中所能看到的其他结构。该模型还能够让机器人从3D地图中提取相关信息,以查询物体和房间的位置,或者行进路径上人们的移动情况。

Carlone表示,除了用作家政助手,采用新型环境心理模型的机器人还适用于其他高端工作,例如,在车间与工人一起工作,或者寻找灾难现场的幸存者等。

目前,机器人视觉和导航主要在两个方面取得了进展:3D绘图以及语义分割。3D绘图是机器人能够在实时探索的同时以三维的方式重建环境,而语义分割可以帮助机器人将环境中的特征分类为语义对象,例如一辆车,一辆自行车,到目前为止,后一项任务都主要在2D图像上完成。

MIT打造的空间感知新模型是首个可以实时生成3D环境地图,同时还可以在3D地图中标注物体、人(与物体不同,人是动态的)和结构等的模型。

该款新模型的关键组件是一个开源库Kimera,该团队之前利用Kimera构建了一个环境的3D几何模型,同时对物体,如是一把椅子还是一张桌子,进行编码。

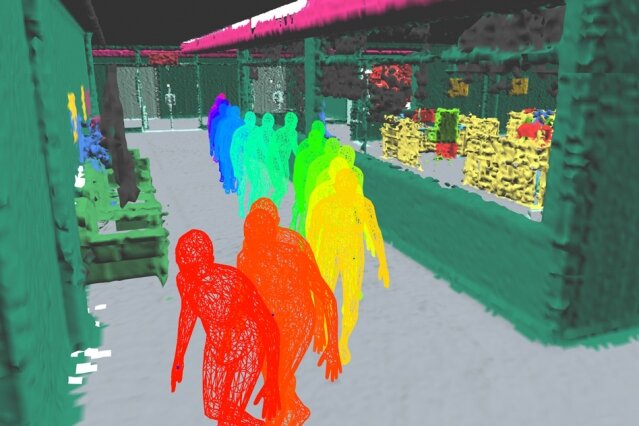

Kimera通过获取机器人摄像头的一系列图像以及机载传感器的惯性测量进行工作,以估计机器人或摄像头的轨迹,并将场景重建为3D网格,所有这些都可实时进行。

为了生成一个3D语义网格,Kimera采用一个现有神经网络(在数百万张真实世界图片得到训练)来预测每个像素的标签,然后利用一种称为射线投射的技术将此类标签投射到3D网格中,此种技术通常在计算机图形学中用于实时渲染。

结果就生成了有关机器人所处环境的地图,与密集的三维网格类似,其中每一面都用颜色编码,是环境中物体、结构和人的一部分。

如果机器人只依靠该网格在环境中进行导航,会是一个计算量大且耗时的任务。因此,研究人员以Kimera为基础,研发算法,从Kimera最初高度密集的3D语义网格中构建3D动态“场景图”。

场景图是非常受欢迎的计算机图形模型,可以操作和渲染复杂场景,通常用于视频游戏引擎,以表示3D环境。

在3D动态场景图中,相关的算法会将Kimera详细的3D语义网格分解为不同的语义层,让机器人可以通过特定的层或镜头“看到”场景。此类语义层逐级延伸,从物体和人到墙壁和天花板等结构、到房间、走廊、大厅,最后到整个建筑物。

研究人员表示,此类语义层避免机器人在原始的3D网格中去了解数十亿个点和面。在物体和人这一层中,研究人员还研发了算法,可实时追踪环境中人类的移动情况和形状。

该团队在与MIT林肯实验室合作研发的逼真仿真器上测试了新模型,该仿真器模拟了机器人在一个有很多人走动的动态办公环境中如何行进。

研究人员表示:“从本质上说,我们让机器人拥有了与人类相似的思维模式。这会影响到许多应用,如自动驾驶汽车、搜救、协同制造和家用机器人等。” 另一个被影响到的领域是增强现实(AR)。想象一下,戴着运行MIT算法的AR眼镜能够帮助处理例如:“我把红色杯子放在哪里了?”和“最近的出口在哪里?”等任务。你可以把它想象成是一个Alexa语音助手,可以感知周围的环境,理解物体、人以及之间的关系。