盖世汽车讯 自动驾驶汽车想要安全地行驶,就需要“了解”周围的事物。自动驾驶汽车可以利用现有的交通状况图像进行练习,从而学习这一能力。据外媒报道,埃因霍温理工大学(TU/e)研究人员Panagiotis Meletis将各种交通图像集合在一起,可提升自动驾驶汽车的感知能力。

(图片来源:techxplore.com)

那个戴着帽子的年轻人是在等人,还是打算过马路?一个球滚到街上,会不会有孩子跑来追它?那辆蓝色的小汽车是要并排泊车,还是要开走?在城市驾驶时,我们需要经常评估这些情况。因此,自动驾驶汽车面临的主要挑战之一是根据“看到”的周围事物,得出正确结论,从而预测意外情况。

Panagiotis Meletis解释称,要更深入地了解交通状况,首先要确定自动驾驶汽车从摄像头接收到的图像中的各种物体。在专注于图像识别的视频编码与架构(Video Coding & Architectures)研究小组中,Meletis参与了移动感知系统实验室(Mobile Perception Systems Lab)的一个项目:自动驾驶汽车定期前往TU/e校园进行测试驾驶。“它需要能够判断看到的是红绿灯、树、行人、自行车,还是车辆。”在更详细的层面上,它还需要能够识别车轮或四肢,因为这些能指示运动方向和道路使用者的意图。

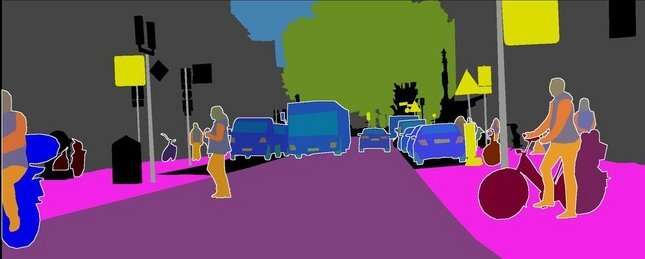

我们可为人工神经网络(AI)提供大量交通情况图像,其中所有相关元素都被标记,来教会其分析交通场景。然后,通过给AI输入新的、未标记的图像来衡量其理解水平。如下图所示,不同的颜色展示了AI是如何解读图像的:汽车是蓝色的,自行车是暗红色的,人的手臂是橙色的,躯干是灰色的。

(图片来源:techxplore.com)

在研究开始时,只有少数公开可用的图像数据集描述交通场景,Meletis表示,“现在有很多数据集,每个都有自己的重点。想想那些包含交通灯、自行车手、行人等的图像。”但是每个数据集都被标记为不同的系统。Meletis在更高的语义层面上,将这些标注连接起来。“例如,汽车、公共汽车和卡车都属于‘车辆’范畴。骑行者、摩托车手和驾驶员都属于‘驾驶员’。在这些定义的帮助下,我能够使用所有可用数据集同时训练AI,产生更好的效果。”

在2018年计算机视觉和模式识别大会组织的一个研讨会上,其中一项比赛是关于“强大视觉(robust vision)”,需要对有视觉影响的交通图像进行分析,如大雨或过度暴露在阳光下。基于包含许多此类低质量图像的数据集,Meletis开发的系统表现优于其他参与者。Meletis还表示,过去的一年,他们成功地编译了两个新的数据集,用于整体场景理解。